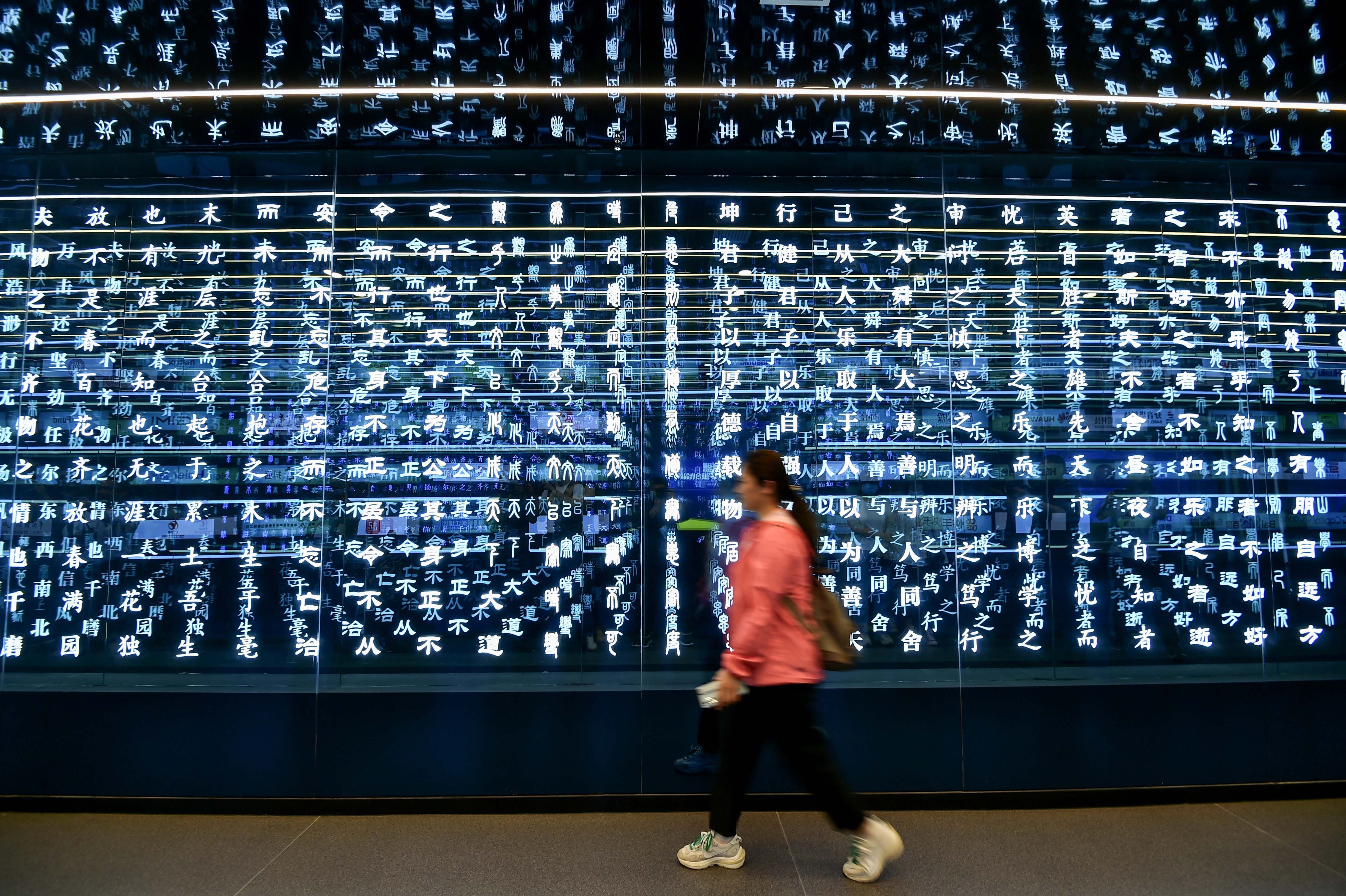

Por una inteligencia artificial con valores humanos

“Este puede ser el año en que la inteligencia artificial transforme la vida cotidiana”. Así lo afirmó Brad Smith, presidente de Microsoft, en un acto sobre inteligencia artificial (IA) organizado por El Vaticano a principios de enero. Pero la declaración de Smith era más una llamada a la acción que una predicción: el evento —al que asistieron líderes de la industria y representantes de las tres religiones abrahámicas— pretendía promover un enfoque ético y antropocéntrico para el desarrollo de la IA.

Publicidad

No cabe duda de que la IA plantea una serie de retos operativos, éticos y normativos enormes. Y abordarlos no será nada sencillo. Aunque el desarrollo de la IA se remonta a la década de los cincuenta, aún no se ha definido el concepto general y su potencial impacto sigue siendo confuso.

Por supuesto, los avances recientes, desde los textos casi (escalofriantemente) humanos producidos por el ChatGPT de OpenAI hasta aplicaciones que podrían reducir en años el proceso de descubrimiento de fármacos, arrojan luz sobre algunas dimensiones del inmenso potencial de la IA. Pero sigue siendo imposible predecir todas las formas en que la IA transformará la vida humana y la civilización.

«Las redes sociales se presentaron inicialmente como una innovación que reforzaría la democracia, pero han contribuido mucho más a desestabilizarla»

Esta incertidumbre no es nueva. Incluso después de reconocer el potencial transformador de una tecnología, la forma que toma esa transformación suele sorprendernos. Las redes sociales, por ejemplo, se presentaron inicialmente como una innovación que reforzaría la democracia, pero han contribuido mucho más a desestabilizarla, al ser una herramienta clave para la propagación de la desinformación. Cabe suponer que la IA se explotará de forma similar.

Ni siquiera entendemos del todo cómo funciona la IA. Consideremos el llamado problema de la caja negra: con la mayoría de las herramientas basadas en IA, sabemos lo que entra y lo que sale, pero no lo que ocurre entre medias. Si la IA toma decisiones (a veces irrevocables), esta opacidad supone un grave riesgo, que se ve agravado por problemas como la transmisión de prejuicios implícitos a través del aprendizaje automático.

El uso indebido de datos personales y la destrucción de puestos de trabajo son otros dos riesgos. Y, según el exsecretario de Estado estadounidense Henry A. Kissinger, la tecnología de IA puede socavar la creatividad y la visión humanas, ya que la información llega a “abrumar” a la sabiduría. Algunos temen que la IA conduzca a la extinción humana.

Con tanto en juego, el futuro de la tecnología no puede dejarse en manos de los investigadores del área, y mucho menos en la de los directores ejecutivos de las empresas tecnológicas. Aunque la respuesta no está en una regulación rígida, hay que llenar el vacío normativo actual. Ese proceso exige el tipo de compromiso mundial amplio. Como el que está dando forma hoy, tras muchos esfuerzos, al de combatir el cambio climático.

De hecho, el cambio climático ofrece una analogía útil para la IA, mucho más útil que la comparación con el armamento nuclear. Este tipo de armas pueden afectar a la población indirectamente, a través de los acontecimientos geopolíticos, pero la tecnología que hay detrás no es un elemento fijo de nuestras vidas personales y profesionales, ni se comparte globalmente. Pero el cambio climático, como la IA, afecta a todo el mundo, y actuar para hacerle frente puede generar diferencias entre países.

«La carrera por dominar la IA es ya una de las claves de la rivalidad entre Estados Unidos y China»

La carrera por dominar la IA es ya una de las claves de la rivalidad entre Estados Unidos y China. Si cualquiera de los dos países impone límites a su industria de IA, corre el riesgo de permitir que el otro se adelante. Por eso, como en el caso de la reducción de emisiones, es vital un enfoque cooperativo. Los gobiernos, junto con otros actores públicos, deben trabajar juntos para diseñar e instalar límites a la innovación del sector privado.

Por supuesto, es más fácil decirlo que hacerlo. El escaso consenso sobre cómo abordar la IA ha dado lugar a una mezcolanza de normativas. Y los esfuerzos por diseñar un enfoque común en los foros internacionales se han visto obstaculizados por las luchas de poder entre los principales actores y la falta de autoridad para hacer cumplir la normativa.

Pero hay noticias prometedoras. La Unión Europea está elaborando un ambicioso instrumento para establecer normas armonizadas sobre IA. El Reglamento de IA, cuya finalización está prevista para este año, pretende facilitar el “desarrollo y la adopción” de la IA en la UE, garantizando al mismo tiempo que la tecnología “funcione para las personas y sea una fuerza positiva para la sociedad”. La propuesta legal incluye desde adaptar las normas sobre responsabilidad civil hasta revisar el marco de la UE para la seguridad de los productos. La ley adopta el tipo de enfoque global de la regulación de la IA que echábamos en falta.

No debe sorprender que la UE se haya situado a la vanguardia de la regulación de la IA. El bloque tiene un historial de liderazgo en el desarrollo de marcos reguladores en áreas críticas. Podría decirse que la legislación de la UE sobre protección de datos inspiró medidas similares en otros lugares, desde la Ley de Privacidad del Consumidor de California hasta la Ley de Protección de la Información Personal de China.

Pero será imposible avanzar en la regulación mundial de la IA sin EEUU. Y, a pesar de su compromiso compartido con la UE para desarrollar e implantar una “IA fiable”, EEUU está comprometido con la supremacía de la IA por encima de todo. Para ello, no solo trata de reforzar sus propias industrias punteras —entre otras cosas, reduciendo al mínimo los trámites burocráticos necesarios para su desarrollo—, sino también de impedir los avances en China.

Como señalaba la comisión de Seguridad Nacional sobre Inteligencia Artificial en un informe de 2021, EEUU debería centrarse en “cuellos de botella que impongan costes estratégicos derivados significativos a los competidores, y costes económicos mínimos a la industria estadounidense”. Los controles a la exportación que EEUU impuso en octubre, dirigidos a las industrias chinas de computación avanzada y de semiconductores, ejemplifican este enfoque. Por su parte, es poco probable que China renuncie a su objetivo de alcanzar la autosuficiencia (y, eventualmente, supremacía) tecnológica.

Además de abrir el camino para que se manifiesten los riesgos generados por la IA, esta rivalidad tecnológica tiene evidentes implicaciones geopolíticas. Por ejemplo, el papel preponderante de Taiwán en la industria mundial de semiconductores le da ventaja, pero también puede ponerle otra diana en la espalda.

Hicieron falta más de tres décadas para que la concienciación sobre el cambio climático se tradujera en acciones reales, y, sin embargo, aún no estamos haciendo lo suficiente. Dado el ritmo de la innovación tecnológica, no podemos permitirnos seguir un camino similar con la IA. A menos que actuemos ahora para garantizar que el desarrollo de la tecnología se guíe por principios antropocéntricos, es casi seguro que nos arrepentiremos. Y, como en el caso del cambio climático, lo más probable es que lamentemos nuestra inacción mucho antes de lo que pensamos.

© Project Syndicate, 2023. www.project-syndicate.org

Breve reflexión bajo un prisma ético de la Inteligencia Artifical (IA) que esta sin resolver.

IA impulsa “entornos VUCA” (Volatility, Uncertainty, Complexity and Ambiguity). No está regulado como tal, ni específicamente. El desarrollo tecnológico va por delante del desarrollo jurídico que otorgue el marco regulatorio adecuado. Genera un vacío difícil de regular porque no conocemos bien el desarrollo y alcance futuro de estas tecnologías ante una revolución que crece exponencialmente. Resulta muy difícil dar un marco jurídico porque tampoco tenemos una respuesta moral. El vehículo autónomo para uso civil está superado técnicamente; pero, el desarrollo ético no lo está: cómo debe de actuar la maquina ante situaciones que son peligrosas, qué opciones de respuesta se deben de programar y cuál debe ser la elegida.

La IA aplicada al un uso militar, se agrava por las consecuencias letales. Nos basamos en lo que conocemos, en lo que esta consensuado que son los principios de Derecho Internacional (DIH & DIDH) para enmarcar las respuestas del uso de armas como AW -anonymous weapons- y RPAs-remoted piloted aircrafts. Es la guerra autómata, rápida, quirúrgica (¿?), sin conciencia (¿?). El campo de batalla es indefinido y amplio. La velocidad de respuesta acción-reacción es trepidante porque la IA analiza una masa ingente de datos en un corto espacio de tiempo donde la mente humana no puede competir. Es más, estas armas inteligentes autónomas evolucionan y “auto aprenden” (machine-learning), pueden decidir qué acciones consideran con graves consecuencias, parece lógico impregnar todo el proceso de normas éticas.

El debate es quien domina a quien; no perdamos el liderazgo delegando en la IA. El uso de la IA implica una aceleración de la toma de decisión que desborda al ser humano, y eso empuja a la delegación; ¿cómo introducir mecanismos de control para impregnar de ética el proceso? ¿Podemos “fabricar” algoritmos éticos?

Ejemplos:

a) La película “Eye in the Sky” (2016), vislumbra la guerra moderna, una guerra de drones. Muestra el componente político, militar y jurídico-ético en el proceso de toma de decisión de atacar una célula del ISIS en Nairobi mediante un RPA militar (dron). Entonces se establece una debate dialectico con una gran carga ética entre las diferentes esferas mencionadas, geográficamente separadas y distantes del punto de objetivo, apoyados por sistemas tecnológicos que permiten tener información on line, y apremiados en el tiempo porque deben tomar una decisión rápida.

b) El derribo del avión ucraniano Boeing 737 de pasajeros (2020) por Irán con misiles Tor-M1. El sistema detecta 42 objetivos en movimiento y dispara misiles contra dos objetivos al mismo tiempo. El sistema tarda entre 5 y 8 segundos en lanzar los proyectiles desde que detecta el blanco. Fue un error de interpretación que considero un blanco hostil, pero si el error fue del operador, la IA podría haberlo evitado; y si fue error del algoritmo, no hubo control humano.