POLÍTICA EXTERIOR > NÚMERO 216

La reinvención de las autocracias

El coche que conducía RoboCop, aquel policía del futuro del cine de los ochenta, era un Ford Taurus. Un coche que cuatro décadas después resulta totalmente anodino. Ni es futurista ni ha envejecido lo suficiente para ser vintage. Pero más viejuno aun que aquel Ford resulta el concepto mismo de que un robot se ponga al volante de un coche, ahora que con la conducción autónoma sabemos que el propio coche es en sí mismo un robot y los robots policiales pueden ser un simple dron. Tampoco lo vio venir Desafío total, esa otra ficción futurista que ha envejecido regular en la que la tecnología permite irse de vacaciones al planeta rojo, pero los robots no parecen nada futuristas sino autómatas del XIX. Schwarzenegger se montaba en un taxi conducido por un robot bastante ortopédico vestido de botones de hotel. Eso era lo que todavía se entendía en los noventa por un coche robotizado: un androide conduciendo.

E igual que la hipervigilancia y la biometría están dejando obsoletas gran parte de las escenas de identificación de sospechosos a las que estábamos acostumbrados en los thrillers policíacos del siglo XX, también los vehículos autónomos pueden acabar con ese subgénero tan característico como son las persecuciones policiales. Si los coches se conducen solos, no va a ser fácil convencer a la máquina de que se salte un semáforo: su sistema mismo le prohíbe una infracción. ¿Iremos todos en el futuro cumpliendo impecablemente y con total uniformidad y parsimonia la distancia de seguridad dentro de nuestros vehículos auto conducidos? ¿Compromete eso la libertad individual o compensa ese control si a cambio garantiza una mayor seguridad?

La duda cobra otra dimensión si encima imaginamos esa tecnología, ya sea la conducción autónoma o el reconocimiento facial, en manos de regímenes autoritarios. Ya no sería de ciencia ficción un agente de policía al que le bastara con geolocalizar en qué vehículo huye el sospechoso para ordenarle que se detenga. No ordenárselo al ciudadano, sino al vehículo mismo. ¿Para qué iban a perseguirlo si lo pueden obligar a que dé la vuelta y se entregue en comisaría? Todo eso puede hacerse con la inteligencia artificial.

Ni cine, ni ciencia ficción

No es ciencia ficción imaginarse una puerta de atrás, no del coche sino del sistema, como la llaman los expertos en ciberdelincuencia, con la que las autoridades puedan tomar el control de los vehículos en caso de detectar una amenaza de seguridad. Los regímenes autoritarios no van a necesitar ni esperar a la orden judicial para interceptar ciudadanos en vehículos autónomos.

Luego están los datos. Los coches conectados, además, guardan un registro de todos los viajes que han hecho sus ocupantes. No va a ser fácil encontrar coartada ni dónde esconderse. Eso está bien para encontrar a los malos. ¿Pero qué pasa cuando los malos son los que tienen el control de la tecnología?

No es una simple anécdota para nostálgicos del cine ochentero que puedan desaparecer las persecuciones policiales y las coartadas improvisadas, sino un ejemplo más de cómo la tecnología para fines de control político y social está llegando a una nueva dimensión.

Para hacernos una idea de cómo la inteligencia artificial va a cambiarlo todo y los desafíos que presenta, nada como imaginarse el uso de ella que pueden hacer las autocracias. O, mejor dicho, las AI-tocracias, como las bautizaron los investigadores Martin Beraja, Andrew Kao, David Y. Yang y Noam Yuchtman del Centre for Economic Performance de la London School of Economics.

Su investigación plantea que la IA puede ser particularmente eficaz para mejorar el control social y político de los regímenes autócratas. La capacidad de predicción y análisis de datos a gran escala en busca de patrones hace la recopilación de datos sensibles mucho más fácil y escalable.

Máquinas con problemas muy humanos

Hace tiempo que expertos en IA y empresarios detrás de su desarrollo advierten de que la inteligencia artificial puede llevarnos a la extinción y se firman manifiestos al respecto. Entre tanto, sobrellevamos las amenazas distópicas de la extinción doblando al inglés a Chiquito de la Calzada con la última app de moda en redes o envejeciéndolos el rostro con un filtro nuevo de Instagram con el que el sistema continúa recopilando ratos biométricos para fines, en el mejor de los casos, comerciales.

La ventaja de entretenernos a los medios con manifiestos que avisan del riesgo de la IA y amenazan con la extinción es que hace que todos los demás riesgos parezcan poquita cosa. Si cada vez que se debate el futuro de la inteligencia artificial llevamos las amenazas a lo existencial, es más fácil para las empresas desarrolladoras de estas tecnologías asegurar que están muy concienciadas con los peligros futuros en vez de asumir sus responsabilidades del presente. También facilita a los gobiernos, especialmente a los autocráticos, alegar que se invierte en esa tecnología para garantizar la seguridad ciudadana.

Mientras se plantea el problema de la IA como si fuera que las máquinas pueden llegar a ser ingobernables en el futuro, no se analiza si el problema del presente es qué tipo de gobiernos pueden crear los humanos que las utilicen. No hace falta una rebelión de las máquinas para temerlas. Ya hay humanos que son bastante temibles. Y más si tienen una IA cada vez más sofisticada a su servicio. Esos riesgos hace tiempo que ya están aquí.

Hace unos años Google tuvo que cancelar con el Pentágono el llamado Proyecto Maven después de que tres mil empleados firmaran una carta en protesta por el uso de la inteligencia artificial para fines militares. El análisis mejorado del vídeo de drones en el que estaban trabajando podría usarse para la identificación de objetivos en ataques y evitar la muerte de inocentes. También Amazon y Microsoft colaboran con el gobierno de Estados Unidos en el desarrollo de tecnología militar y prevención de acciones antiterroristas, pero los empleados de Google fueron los primeros que denunciaron que la tecnología que estaban desarrollando podría sobrepasar la línea de la vigilancia para pasar a ser letal.

Decisiones deshumanizadas

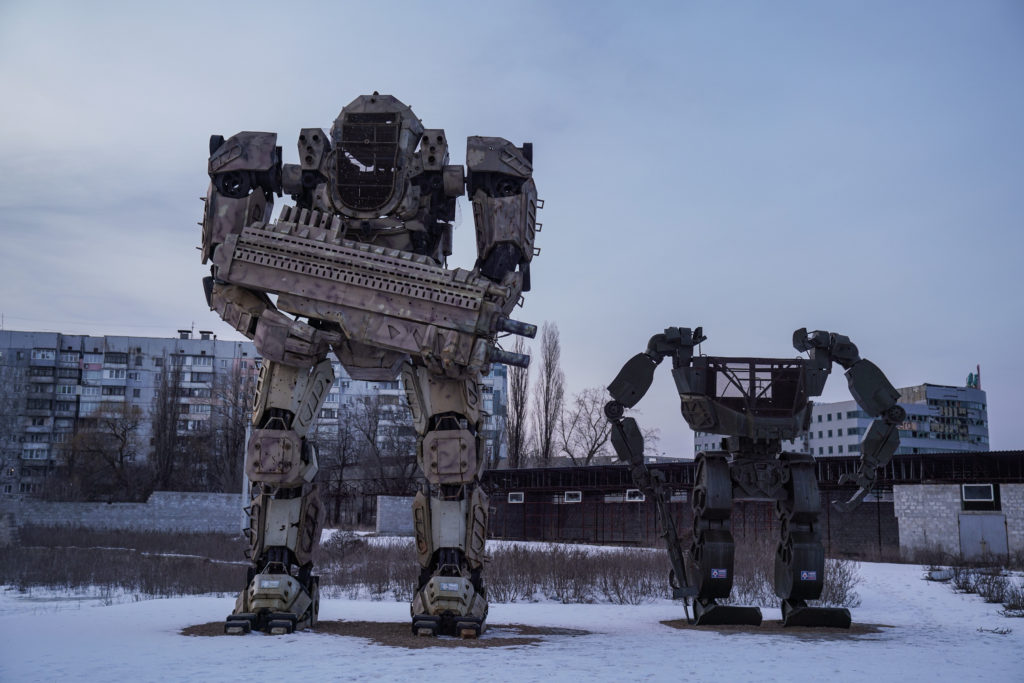

¿Cómo distingue la máquina de matar en su propio vuelo entre el terrorista de 18 años y el chico de 18 años que está cazando conejos? Los ingenieros que dimitieron del Proyecto Maven creían que no podría. No querían ser los causantes de que uno de los drones confundiera con enemigos insurgentes a simples cazadores. Estos sistemas autónomos solo pueden entrenarse, como pasa con los vehículos autónomos, en el mundo real, es decir, en zonas de combate. Solo sabrían si acertó o no después de tomar la decisión y se la negaron.

Muchos expertos reclaman por ello un protocolo internacional como el que hay con el armamento químico y el nuclear. Uno de los riesgos es que los robots potencialmente asesinos que ya se están fabricando iniciaran accidentalmente una guerra. De ahí que pidan que siempre haya un control humano que sea el que tome las decisiones. El problema se agrava, claro, cuando el humano que toma las decisiones en cuestión es un dictador.

El estudio citado de la LSE encuentra que la IA fortalece el control político de los autócratas. No es casualidad por tanto que China se encuentre entre los países líderes en desarrollo de reconocimiento facial, uno de los campos más importantes de la tecnología de inteligencia artificial. Las autocracias invierten mucho en los avances de estas tecnologías de control sin tener que dar explicaciones.

Otro dato que aportan estos investigadores es que los lugares que experimentan disturbios políticos compran más cámaras de video de alta resolución. Captan así datos cruciales para seguir alimentando la tecnología de reconocimiento facial. Así, el gobierno chino adquiere IA como parte de un esfuerzo por mejorar el control político, lo que a su vez le permite convertirse en una potencia tecnológica.

China en la vanguardia

Hace años que el gobierno chino ya ha implantado el sistema de crédito social con el que la serie Black Mirror fantaseaba. Los ciudadanos tienen una puntuación basada en sus acciones cívicas y morales. El impago de una factura o molestar a los vecinos con la música demasiado alta puede bajar el marcador de crédito social. También quita puntos arrojar colillas al suelo, cruzar la calle con el semáforo en rojo y gritar en el metro (la tupida red de cámaras de reconocimiento facial ayuda a vigilar estos comportamientos). De disidencia política, ni hablamos.

Al sistema chino de crédito social hay que sumarle además las apps de estricto control sanitario que se impusieron en China con la llegada del coronavirus como gran laboratorio del uso de herramientas tecnológicas para control social. Al rastreo de movimientos para saber si la persona había estado cerca de algún foco de contagio se sumó un sistema para identificar a las personas con tres colores (verde, amarillo o rojo), que calculaba el riesgo de estar infectado. Cruzando diferentes variables (nada transparentes), el algoritmo decidía qué personas pueden o no salir de casa y a cuáles autorizaba para entrar al metro o al supermercado. Un código QR acreditaba el buen estado de salud de las personas con derecho a comprar un billete de tren o a entrar en un McDonald’s.

Pero antes de que llegaran estos mecanismos de control sanitario, en China ya funcionaba el sistema de crédito social. Los que pasan a su lista negra tienen menos derechos que los ciudadanos ejemplares. No pueden, por ejemplo, viajar en avión, conseguir una hipoteca o trabajar como funcionarios públicos, ni los querrán contratar algunas empresas. Como en la distopía futurista de Black Mirror pero en la realidad del presente.

En este ambicioso sistema digital pensado para controlar a 1.400 millones de personas tanto en el mundo online como en el físico, los ciudadanos más obedientes tienen ventajas. Algunas inmobiliarias chinas ofrecen, por ejemplo, descuentos de hasta el 50 por ciento en los alquileres a los inquilinos que más confianza inspiran al sistema. Lin Junyue, el académico considerado el padre del crédito social, defiende este sistema de control como mecanismo para incentivar que la gente se porte bien y no delinca. Lin piensa, igual que el Gobierno chino, que las libertades individuales están sobrevaloradas, que merece la pena el sacrificio. Los ciudadanos chinos no tienen mucha opción para decidirlo por sí mismos.

Este sistema de control social desplegado por China resume como pocos el potencial de la IA para reforzar la vigilancia ciudadana y restringir tanto la libertad de movimiento como el derecho al a privacidad y la propia imagen como la libertad de expresión. En definitiva, la libertad.

Desinformación

Las implicaciones de la IA en la política no solo pasan por las tecnologías de vigilancia, las herramientas de reconocimiento facial y la recopilación masiva de datos online. Otra de las amenazas para las democracias, o lo que es lo mismo, otra oportunidad para las autocracias, es el nivel de desinformación y manipulación que puede generar y difundir la nueva IA generativa.

Igual que las plataformas de redes sociales utilizan algoritmos para influir en lo que los usuarios ven, en las autocracias se pueden utilizar, se usan ya de hecho, para enfatizar el compromiso con el régimen, censurar disidencias y difundir información manipulada. La censura ya existía antes, claro, pero una vez más la escala y el nivel de control que permite la inteligencia artificial es otra dimensión.

Son muchos los riesgos de una tecnología que cada vez va a hacer más difícil diferenciar lo que es verdad de lo que no. No solo en lo que leemos, también en lo que vemos con nuestros propios ojos con los deep fake. El catedrático Julio Gonzalo, director del grupo de investigación en procesamiento del lenguaje natural de la UNED, explica que el riesgo del caos es mayor, más inminente y más mundano de lo que parece.

«La IA está avanzando cada vez más deprisa, pero no lo hacen la regulación ni el análisis de los cambios que trae consigo en el debate público»

La tecnología es nueva. Los temores, no. El miedo al usado que las autocracias pueden hacer de una tecnología como ésta ya estaban en Fahrenheit 451, en Matrix y más allá. Al riesgo de que la IA generativa pueda utilizarse para generar información falsa a propósito, y para el control de los mensajes desde el control político en las autocracias, hay que sumarle el de que lo puede hacer también sistemáticamente y sin querer. Con tecnologías como el ChatGPT se avecina una nueva oleada de información errónea a medida sin que seamos capaces de diferenciar qué hay de cierto o falso en ello. Y en ese clima de desconfianza, el derecho a la información se ve gravemente amenazado y erosiona las democracias.

ChatGPT de momento se equivoca mucho porque crea respuestas procesando todo tipo de datos que encuentra en la red haciendo un cálculo de probabilidad. Y, lo más peligroso de todo, con una alta apariencia de fiabilidad. Es decir, ChatGPT genera respuestas a medida que parecen creíbles, pero que a menudo no lo son. Otras veces sí. Otra tecnología, por tanto, que puede facilitar a los regímenes autoritarios no solo el control de sus mensajes, también la capacidad de generarlos a gran escala si lo programan para ello.

Como dicen Acemoglu y Johnson en Poder y Progreso la IA es una magnífica oportunidad para mejorar la productividad, el crecimiento económico y hasta para aumentar no solo la calidad, también la esperanza de vida gracias a las ayudas en investigación médica.

La inteligencia artificial podría desarrollarse como una fuerza beneficiosa. Sin embargo, van quedando pocas dudas de los riesgos que plantea como herramienta de control social.

Así que antes de preocuparnos por qué pasaría si en el futuro las máquinas de inteligencia artificial se rebelan, urge plantearse qué está pasando con las máquinas que ya están en manos de regímenes autocráticos y cómo el mal uso de estas tecnologías puede erosionar las democracias y las libertades individuales si no se les exige responsabilidades también a las empresas que lo desarrollan.

La IA puede ser una tecnología de progreso o la que amenace las instituciones democráticas, facilite el control social de los autócratas y limite derechos fundamentales como la privacidad y la libertad de expresión.

La IA está avanzando cada vez más deprisa, pero no lo hacen la regulación ni el análisis de los cambios que trae consigo en el debate público. Y con la IA al alcance de todos, en vez de preguntarnos qué pasa si las máquinas se vuelven realmente inteligentes, más urgente es preguntarse qué riesgos corremos cuando cae en manos de humanos de poco fiar en general y autócratas en particular. No es la inteligencia artificial la que amenaza la humanidad, los humanos somos perfectamente capaces de hacer ese trabajo nosotros solos.